Limits und Ressourcenverbrauch bei AI

Prognosen und Analysen der Internationalen Energieagentur

Der Stromverbrauch von großen Sprachmodellen (LLMs) ist immer wieder Gesprächsthema. Dieser Artikel versucht etwas Licht ins Dunkel zu bringen.

Das Training von LLMs ist sehr energieintensiv, da es große Mengen an Rechenleistung erfordert und diese Modelle oft Wochen oder monatelang auf riesigen Datensätzen trainiert werden. Bei der sogenannten Inference (d.h. der Nutzung des Modells zur Generierung von Text) ist der Energieverbrauch niedriger, summiert sich aber auf, wenn das Modell von tausenden Usern eingesetzt wird.

Das Training von GPT-3 soll mehr als 1.300 Megawattstunden verbraucht haben (ungefähr der jährliche Stromverbrauch von 130 US-Haushalten) und es heisst, das Generieren eines Bildes per AI entspricht einer vollen Smartphone-Aufladung. (Quelle: Power Hungry Processing: Watts Driving the Cost of AI Deployment?). Microsoft hat einen Vertrag abgeschlossen, um den durch den Unfall bekannten Atomreaktor Three Mile Island wieder zu eröffnen, um seine Datencenter mit Strom zu versorgen.

Auch als sich der Siegeszug des Internets abzeichnete, wurde ein enormer Energiehunger befürchtet. Aus einem FORBES-Artikel aus 1999: “The global implications are enormous. Intel projects a billion people on-line worldwide. […] One billion PCs on the Web represent an electric demand equal to the total capacity of the U.S. today.”

Wo stehen wir bei Artificial Intelligence?

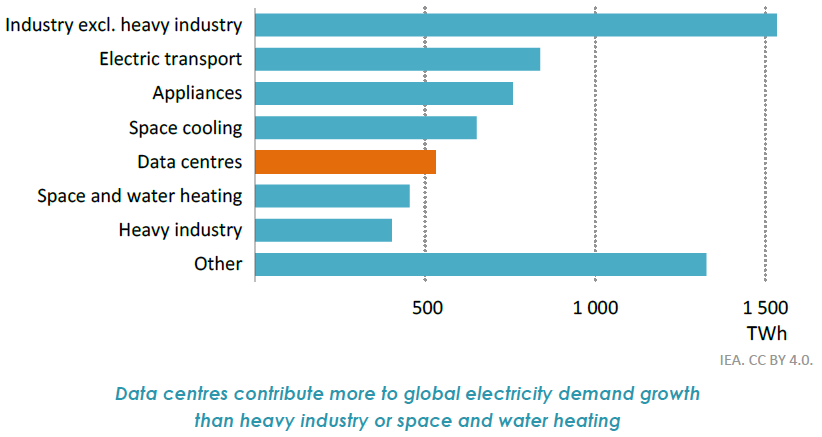

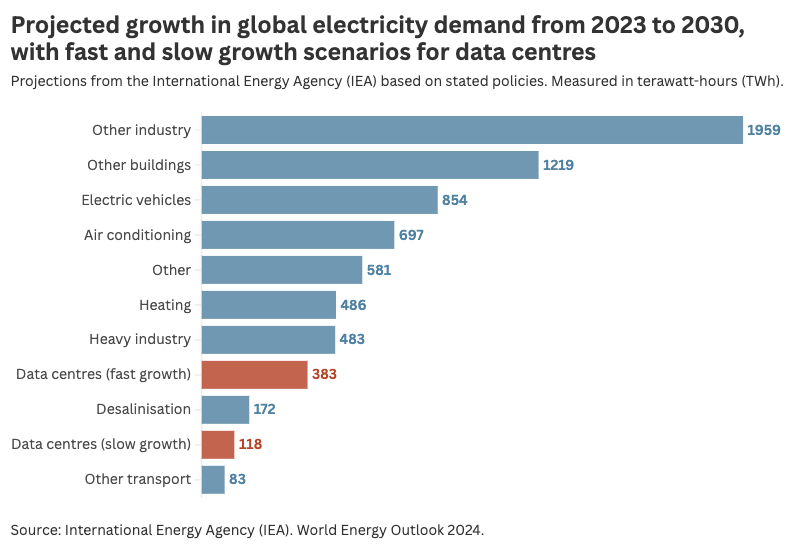

Es zeichnet sich ab, dass der Energieverbrauch steigen wird, aber nicht exorbitant. Der World Energy Outlook 2024 Report der Internationalen Energie Agentur geht davon aus, dass der Energieverbrauch von Datencentern und AI für die nächsten fünf Jahre relativ gering bleiben wird. Zudem relativiert sich dieser Energieverbrauch, wenn man die Zahlen mit anderen Branchen vergleicht. Für andere Industrien, E-Autos und Klimaanlagen wird ein viel größerer Energiehunger prognostiziert – siehe Diagramm (Es zeigt sowohl geringes als auch starkes AI Wachstum. Quellen: IAE; Hannah Ritchie (sustainabilitybynumbers.com)):

Hintergründe

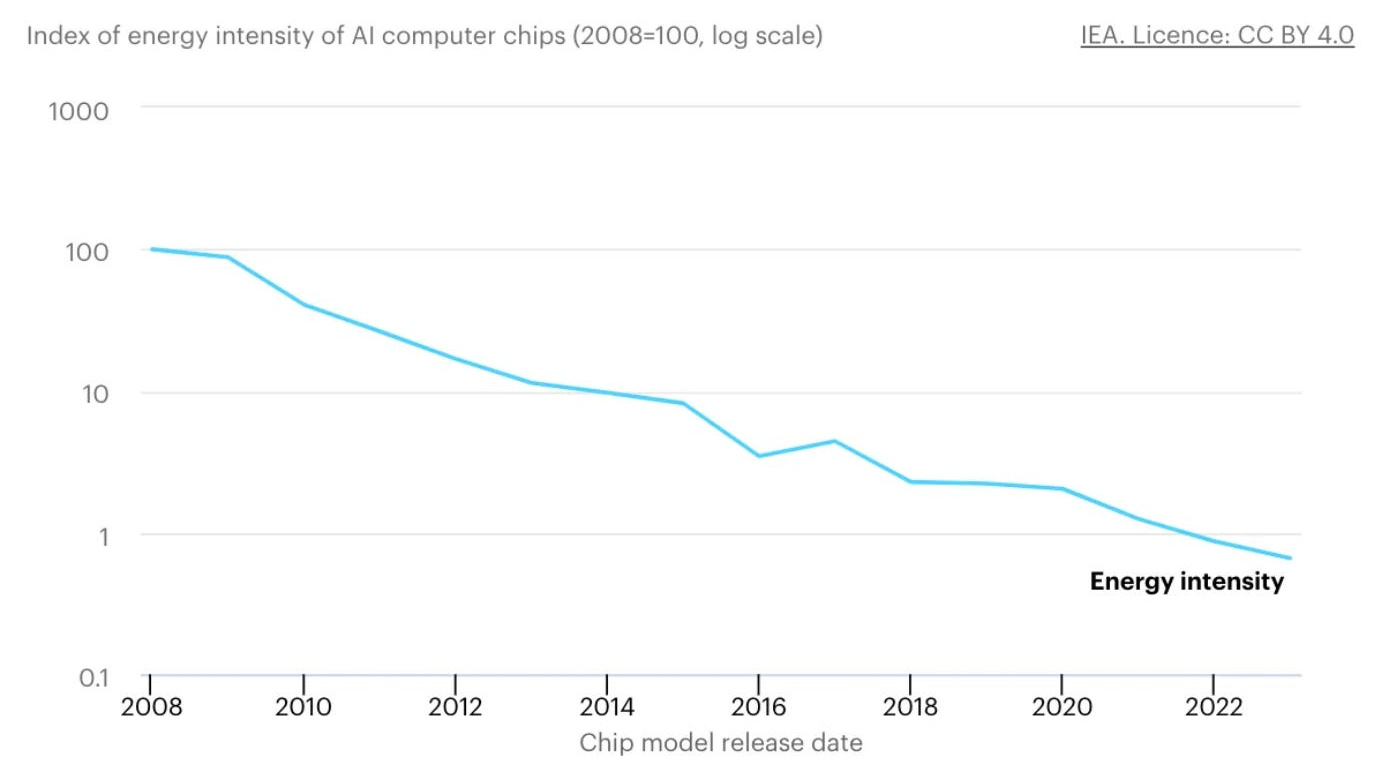

Die zuvor erwähnte Forbes-Prognose, wonach die Internetrevolution zu einer Verdoppelung des US-Energieverbrauchs führen wird, ist nicht eingetreten. Und die gleichen Gründe könnten auch dafür sorgen, dass der Stromverbrauch von AI nicht exorbitant steigen wird.

Zwischen 2010 und 2018 stieg die Rechenleistung aller Datencenter um mehr als 550%, während diese nur 6% mehr Strom benötigten. ( Quelle: Recalibrating global data center energy-use estimates)

Diese (logarithmische) Darstellung zeigt die stetig steigende Energieeffizeinz von Computer Chips. Die Energieintensität dieser Chips beträgt weniger als 1% im Vergleich zu 2008:

Zukunftsprognosen

NVIDIA dominiert mit 95% der globalen Verkäufe den Markt für AI Server. Wie schnell der Energieverbrauch durch AI steigen kann, hängt tatsächlich von den Produktionskapazitäten von NVIDIA ab.

Zur Zeit ändern sich die Anforderungen an die Datencenter: Neueste AI-Entwicklungen setzen stark auf „Reasoning-Modelle“, wo Aufgaben in einem mehrstufigen Ablauf zerlegt, analysiert und gelöst werden – nachvollziehbare Schlussfolgerungen in Echtzeit. Dafür benötigt man hohe Übertragungsgeschwindgkeiten, wohingegen der Fokus auf das Training von LLM-Modellen bisher monatelange Verarbeitung umfangreicher Datenmengen erfordert hat. Gleichzeitig scheint das leistungstarke chinesische Modell DeepSeek nur einen Bruchteil des Trainingsaufwands zu benötigen. Erste Auswirkungen sind bereits sichtbar: In China sind eine Vielzahl neu errichteter Datencenter ungenützt und Microsoft stoppt die Erweiterung seiner Datencenter.

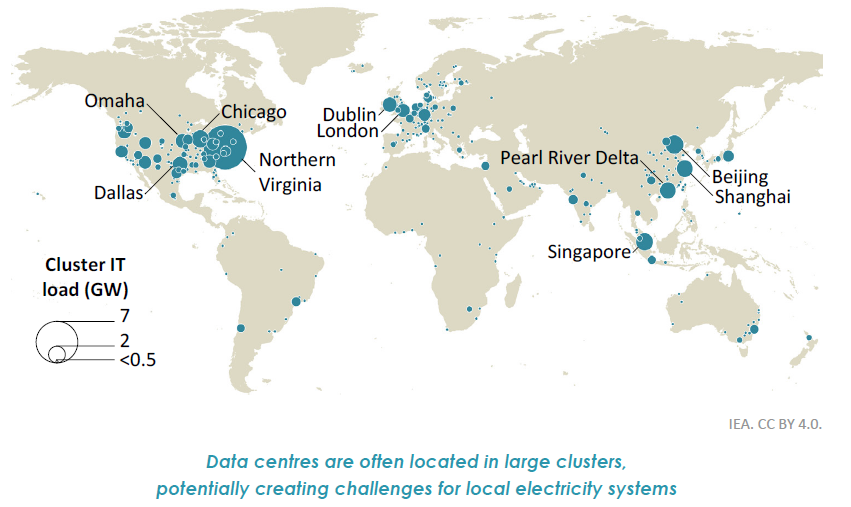

Die Internationale Energie Agentur schätzt, dass Datencenter und Kryptowährungen „nur“ ca 2% des weltweiten Stromverbrauchs ausmachen – wobei dieser Anteil in einigen Ländern weitaus höher ist – in Irland sorgen Datencenter für ca. 17% des nationalen Stromverbrauchs. Energie kann trotzdem ein Engpass werden, weil der Energieverbrauch von AI örtlich begrenzt schnell steigt, denn Datencenter können schnell errichtet werden, aber die Errichtung der Stromversorgung und Stromleitungen ist viel langwieriger.

Schlusswort: Es muss darauf hingewiesen werden, dass die meisten Schätzungen und Zukunftsprognosen zum Energieverbrauch sehr ungenau sind. Es ist sicher, dass AI mehr und mehr Energie brauchen wird. Aber möglicherweise weniger als gemeinhin angenommen. Zitat der Internationalen Energieagentur: “Data centres account for a small share of global electricity demand growth to 2030, and plausible high and low sensitivities do not change the outlook fundamentally.”

UPDATE April 2025: Die IAE hat im jüngsten Report die Schätzung (Steigerung des Energieverbrauchs bis 2030) angepasst: